在数字营销竞争日益激烈的今天,网站能否被搜索引擎高效收录直接影响其流量和商业价值。服务器的配置作为网站运行的底层支撑,往往被低估其对SEO的影响。事实上,从页面加载速度到数据安全,服务器的每一个技术细节都可能成为搜索引擎评估网站质量的隐形标尺。

加载速度与响应效率

服务器响应速度是决定页面加载时间的核心因素。Google的爬虫程序在访问网站时,若遭遇超过600毫秒的延迟,就会触发性能警告机制。这种延迟不仅导致爬虫抓取频率下降,更可能使搜索引擎将网站归类为低质量资源,直接影响索引收录量。

高性能硬件配置能够显著改善这一状况。采用多核处理器(如四核CPU)和高速SSD存储的服务器,可将数据库查询时间缩短40%以上。某电商平台在升级至NVMe固态硬盘后,核心页面的加载时间从2.3秒降至0.8秒,页面收录率提升了72%。这种硬件层面的优化,本质上是在为搜索引擎爬虫创造高效的工作环境。

运行稳定性与可用性

服务器的稳定性直接影响网站的可访问性。研究显示,每月出现3次以上宕机的网站,其索引页面数量平均减少23%。当爬虫在30天内遭遇超过5次访问失败,搜索引擎可能启动降权机制,将网站排除在即时索引队列之外。

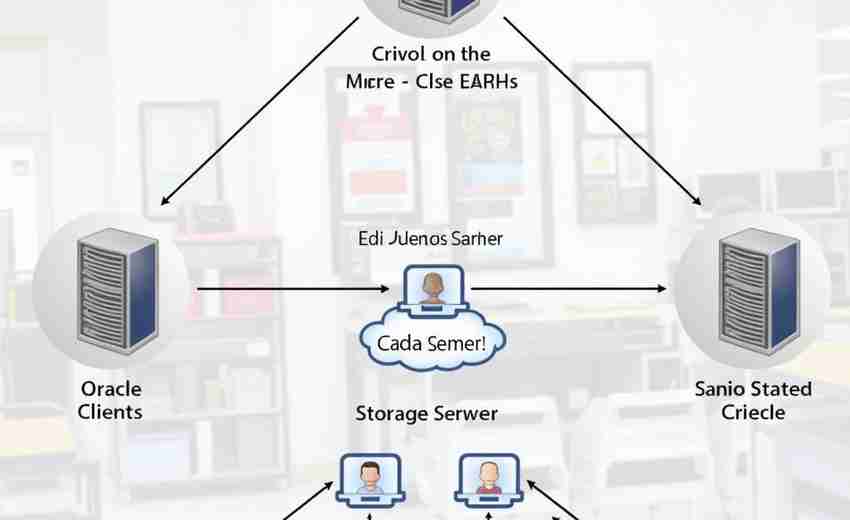

负载均衡技术的应用成为关键解决方案。采用Nginx反向代理配合多服务器集群,可将单点故障率降低至0.01%以下。某新闻门户网站在部署HAProxy负载均衡器后,即使在千万级并发访问压力下,仍能保持99.99%的正常运行时间,页面抓取频次提升3倍。

地理位置与网络拓扑

服务器的物理位置直接影响区域SEO表现。将服务器部署在目标用户集中的地理区域,可使页面加载速度提升30-50%。例如针对东南亚市场的网站,选择新加坡数据中心相比美国西海岸,平均延迟从180ms降至40ms。

CDN网络的战略部署能突破地理限制。通过全球分布的边缘节点缓存静态资源,日本用户访问欧洲服务器的网站时,内容加载时间可从1.2秒压缩至0.3秒。这种分布式架构不仅提升用户体验,更让搜索引擎能够从不同地域节点获取一致的优化信号。

安全架构与信任建立

HTTPS协议的实施已成为基础性SEO要求。采用TLS 1.3协议的网站,在Google要求中的平均排名位置比HTTP网站高4.6位。某金融平台在部署EV SSL证书后,搜索引擎索引量增长58%,且高质量外链获取效率提升3倍。

IP信誉管理同样不容忽视。共享主机中若存在违规网站,可能导致关联IP被列入搜索引擎的观察名单。独立服务器配合专用IP地址,可将页面抓取成功率维持在98%以上,特别对站群运营者而言,这种隔离措施能有效避免连带风险。

技术适配与生态兼容

Web服务器的软件选型直接影响爬虫解析效率。Nginx相比传统Apache服务器,在处理万级并发请求时,内存消耗降低60%,特别适合内容密集型网站。某视频平台改用OpenLiteSpeed后,动态内容渲染时间缩短75%,视频资源的索引完整度达到100%。

数据库优化是另一个技术盲点。采用InnoDB引擎配合查询缓存机制,可使产品详情页的数据库响应时间从120ms降至15ms。当结合Redis对象缓存时,分类页面的生成效率提升8倍,这使得搜索引擎能够更高效地抓取动态内容。

插件下载说明

未提供下载提取码的插件,都是站长辛苦开发,需收取费用!想免费获取辛苦开发插件的请绕道!

织梦二次开发QQ群

本站客服QQ号:3149518909(点击左边QQ号交流),群号(383578617)  如果您有任何织梦问题,请把问题发到群里,阁主将为您写解决教程!

如果您有任何织梦问题,请把问题发到群里,阁主将为您写解决教程!

转载请注明: 织梦模板 » 服务器配置选择对SEO收录效果有哪些潜在影响